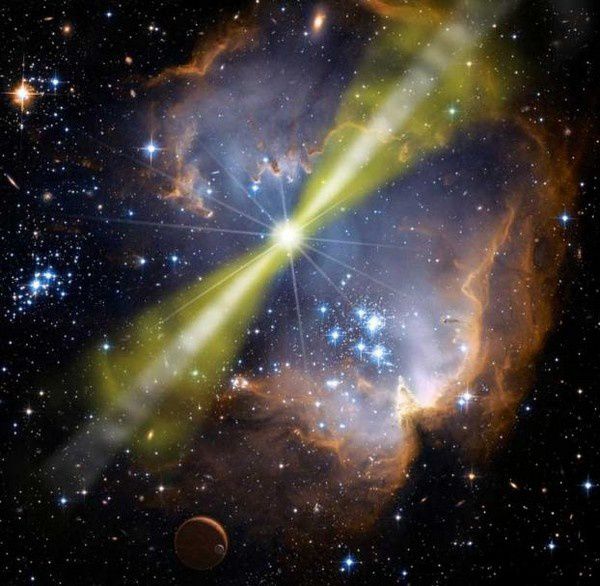

Le jour de Noël 2010, le satellite Swift - qui observe le cosmos depuis 6 ans à la recherche de ces énormes émissions de lumière que l’on appelle des sursauts gamma – détecte une énorme bouffée de photons (particules de lumière) dans la direction de la galaxie d’Andromède, notre plus proche voisine. Il faut toutefois se dépêcher de l’observer car on sait que ces éruptions brutales ne durent pas longtemps : de une à quelques dizaines de secondes au maximum. Swift communique instantanément les coordonnées de l’émission lumineuse aux télescopes terrestres afin qu’ils puissent rapidement « verrouiller » leur cible et débuter leurs observations puis il continue la surveillance du phénomène. Sauf que le temps passe, que les dizaines puis les centaines de secondes s’écoulent sans que le flux de photons ne faiblisse. Au total, le sursaut gamma dure presque 30 minutes (et peut-être même beaucoup plus car Swift est obligé de passer derrière la Terre - dont il fait le tour - en perdant forcément la liaison). IL y avait des sursauts gamma courts (une seconde) et des longs (plusieurs dizaines de secondes) : voilà qu’une nouvelle forme de ce phénomène apparaît, les sursauts ultra-longs. De quoi s’agit-il donc ? Que s’est-il passé du côté de la galaxie voisine de la nôtre ? Et, d’une façon générale, ces sursauts gamma que l’on peut qualifier d’événements les plus violents de l’Univers, c’est quoi en définitive ?

Une découverte récente

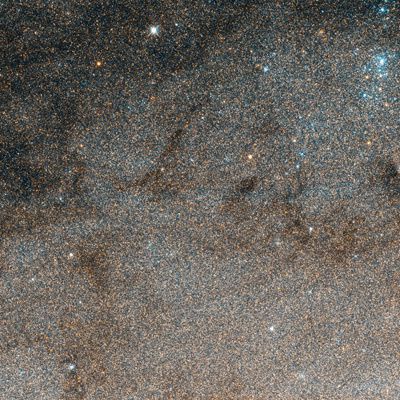

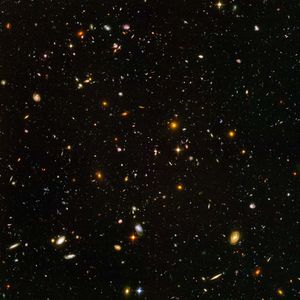

Les sursauts gamma sont des bouffées de photons qui apparaissent au hasard dans le cosmos. Situés à de très grandes distances, parfois à des milliards d’années-lumière (ce qui, rappelons-le veut également dire des milliards d’années dans le passé), ils sont visibles de notre modeste planète parce qu’il s’agit des événements les plus lumineux et violents de l’Univers (en intensité ils sont classés juste après le Big bang).

Leur découverte est relativement récente puisque datant de la « guerre froide » et plus précisément de l’année 1967, lorsque les satellites militaires américains qui les observèrent pour la première fois laissèrent penser qu’il s’agissait probablement de l’empreinte d’armes nucléaires : il faut dire qu’on cherchait alors à vérifier le respect du traité d’interdiction des essais atomiques atmosphériques ! Cette ambiance bien particulière poussa les responsables à ne rendre publiques ces observations que dix ans plus tard. Mais, même à cette époque, on ne savait toujours pas grand-chose de ces phénomènes sauf qu’ils étaient variables en intensité et parfaitement aléatoires donc imprévisibles. C’est quelques années plus tard qu’on mit en évidence deux types différents d’émissions : les sursauts courts et les sursauts longs. Enfin, quelques années plus tard encore, en 1997, grâce au satellite italo-hollandais BeppoSax, équipé à la fois d’un détecteur gamma et d’un détecteur de rayons X, on arriva à orienter l’étude du phénomène vers une source supposée responsable.

laissèrent penser qu’il s’agissait probablement de l’empreinte d’armes nucléaires : il faut dire qu’on cherchait alors à vérifier le respect du traité d’interdiction des essais atomiques atmosphériques ! Cette ambiance bien particulière poussa les responsables à ne rendre publiques ces observations que dix ans plus tard. Mais, même à cette époque, on ne savait toujours pas grand-chose de ces phénomènes sauf qu’ils étaient variables en intensité et parfaitement aléatoires donc imprévisibles. C’est quelques années plus tard qu’on mit en évidence deux types différents d’émissions : les sursauts courts et les sursauts longs. Enfin, quelques années plus tard encore, en 1997, grâce au satellite italo-hollandais BeppoSax, équipé à la fois d’un détecteur gamma et d’un détecteur de rayons X, on arriva à orienter l’étude du phénomène vers une source supposée responsable.

Différents types de sursauts gamma

Nous avons déjà eu l’occasion d’évoquer les rayons gamma lors du sujet traitant des rayons cosmiques : le rayonnement cosmique est un flux de noyaux atomiques (protons principalement mais aussi noyaux d’hélium) et de particules de haute énergie (qu’on nomme également « relativistes » parce que proches de la vitesse de la lumière telle que définie par la théorie de la relativité générale). Leur origine provient de processus astrophysiques extrêmement violents au cours desquels s’observent également des flashs intenses de photons gamma. On a assez rapidement rapproché l’émission de ces photons gamma de la mort d’étoiles et de la formation de trous noirs. Toutefois, il existe à l’évidence deux phénomènes de nature différente.

Les sursauts longs (plusieurs dizaines de secondes) ont été corrélés sans trop d’hésitation à la mort dune étoile massive, c'est-à-dire, comme  nous l’avons déjà vu, d’une étoile faisant plus de huit fois la masse de notre Soleil. En effet, lorsqu’elle se retrouve « à court de carburant », une telle étoile voit les réactions nucléaires, qui jusque là se produisaient en son cœur, se ralentir et s’affaiblir au point de ne plus pouvoir contrebalancer le poids de ses couches externes. Celles-ci s’effondrent vers le centre de plus en plus dense de l’étoile : les moins massives de ces étoiles géantes donneront une étoile à neutrons tandis que les plus grosses voient leur cœur être remplacé par un trou noir. Ce trou noir va absorber une grande partie de la matière externe de l’étoile géante et en recracher le reste sous la forme de deux jets opposés composés de matière brûlante éjectée à une vitesse proche de celle de la lumière : il suffit que l’un de ces jets pointe en direction de la Terre pour que l’on observe l’extraordinaire explosion de l’étoile géante. Et cela même si elle est très éloignée de nous car l’émission d’énergie est en effet

nous l’avons déjà vu, d’une étoile faisant plus de huit fois la masse de notre Soleil. En effet, lorsqu’elle se retrouve « à court de carburant », une telle étoile voit les réactions nucléaires, qui jusque là se produisaient en son cœur, se ralentir et s’affaiblir au point de ne plus pouvoir contrebalancer le poids de ses couches externes. Celles-ci s’effondrent vers le centre de plus en plus dense de l’étoile : les moins massives de ces étoiles géantes donneront une étoile à neutrons tandis que les plus grosses voient leur cœur être remplacé par un trou noir. Ce trou noir va absorber une grande partie de la matière externe de l’étoile géante et en recracher le reste sous la forme de deux jets opposés composés de matière brûlante éjectée à une vitesse proche de celle de la lumière : il suffit que l’un de ces jets pointe en direction de la Terre pour que l’on observe l’extraordinaire explosion de l’étoile géante. Et cela même si elle est très éloignée de nous car l’émission d’énergie est en effet colossale et visible dans tout l’Univers. À cette occasion, l’étoile mourante peut éclipser toutes les autres étoiles de sa galaxie qui sont pourtant des milliards. Précisons que la mort de telles étoiles est finalement assez rare : depuis l’invention du télescope il y a plusieurs siècles, aucune n’a été observée dans notre galaxie.

colossale et visible dans tout l’Univers. À cette occasion, l’étoile mourante peut éclipser toutes les autres étoiles de sa galaxie qui sont pourtant des milliards. Précisons que la mort de telles étoiles est finalement assez rare : depuis l’invention du télescope il y a plusieurs siècles, aucune n’a été observée dans notre galaxie.

Les sursauts courts, c’est une autre affaire et il faut bien avouer qu’il a été plus difficile de les expliquer. Il faut attendre 2005 et l’observation localisée d’un sursaut court par le satellite HETE-2 pour se rendre compte que les caractéristiques des galaxies contenant des sursauts courts sont bien différentes des autres. De ce fait, on n’a certainement pas affaire en  pareil cas à la fin d’une étoile massive mais à un phénomène impliquant une étoile double (binaire) : ici, les protagonistes en présence sont des objets très denses comme une étoile à neutrons ou un trou noir. En se rapprochant, les objets de la binaire finissent par fusionner en émettant un flash de photons gamma, intense mais bref.

pareil cas à la fin d’une étoile massive mais à un phénomène impliquant une étoile double (binaire) : ici, les protagonistes en présence sont des objets très denses comme une étoile à neutrons ou un trou noir. En se rapprochant, les objets de la binaire finissent par fusionner en émettant un flash de photons gamma, intense mais bref.

La lumière, on l’a dit, a une vitesse de propagation de 300 000 km/seconde environ. Bien que cette vitesse soit très élevée (en terme de capacités humaines), l’Univers est si vaste qu’il faut aux rayons lumineux des milliards d’années pour nous parvenir des endroits les plus éloignés de nous. Ce qui veut dire également qu’une source lumineuse si lointaine sera atténuée et difficilement identifiable au sein des milliards d’étoiles plus proches. On saisit donc pourquoi, en dehors de la compréhension des phénomènes proprement dits, les sursauts gamma ont un grand intérêt documentaire : visibles de très loin, ils nous renseignent sur les galaxies lointaines et, par conséquent, sur les premiers instants de notre univers.

Sursauts gamma ultra-longs

Depuis 2010 et le satellite Swift, on a donc affaire à ce qui est peut-être un troisième genre de sursauts gamma, ceux qui durent vraiment plus longtemps que les autres. Par quoi peuvent-ils bien être générés ? Baptisé du doux nom de GRB 101225A, le sursaut gamma observé par Swift donne lieu à plusieurs hypothèses. On évoque tout d’abord, au sein d’une étoile binaire, la fusion d’une étoile à neutrons avec une étoile normale comme le Soleil mais en train de mourir et donc au stade de géante rouge : la fusion des deux aurait donné un trou noir et les événements, notamment lumineux, y afférent. Une autre hypothèse met en scène une comète tombant sur une étoile à neutrons appartenant forcément à notre propre galaxie et donc beaucoup plus proche que primitivement imaginé, à peut-être 10 000 années-lumière de nous.

lumineux, y afférent. Une autre hypothèse met en scène une comète tombant sur une étoile à neutrons appartenant forcément à notre propre galaxie et donc beaucoup plus proche que primitivement imaginé, à peut-être 10 000 années-lumière de nous.

C’est à ce moment de la réflexion des chercheurs que des études plus approfondies de la distance du phénomène montrent qu’il est en fait éloigné de… 7 milliards d’années-lumière, bien au-delà da la galaxie d’Andromède ! Beaucoup plus loin que ce que l’on avait jamais pensé… et provoqué par quelque chose d’énorme. On en revient aux étoiles géantes.

On repense à nouveau complètement la question. Nous savons que le sursaut gamma dure le temps que mettent les couches externes d’une étoile pour tomber sur le cœur : quelques minutes au plus dans le cas d’une étoile massive. Comment expliquer des dizaines de minutes, voire presque deux heures pour une observation plus récente ? Il faudrait que l’étoile en cause soit absolument monstrueuse, d’une taille si importante que les scientifiques considèrent cela comme impossible.

Impossible parce que, pour entretenir un sursaut gamma de cette importance, il faudrait une étoile d'un volume égal à des millions de Soleils ! Et une telle étoile, si elle existe, ne pourrait de toute façon pas émettre un tel sursaut gamma : les étoiles géantes de ce type perdraient en effet jusqu’au trois-quarts de leur masse au cours de leur vie, une matière qui ne serait donc plus disponible par la suite… Alors ?

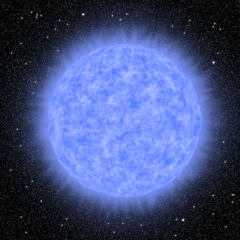

Il existe une autre explication possible : une étoile dont les couches externes seraient perméables aux différentes radiations ce qui permettrait alors à ces enveloppes externes de rester autour du cœur de l’étoile jusqu’à sa mort. De telles étoiles existent (ou ont existé) : ce sont les étoiles primordiales que nous avons évoquées à plusieurs reprises sur ce blog. Au total, on se trouve devant une supergéante bleue presque exclusivement composée d’hydrogène et d’hélium avec très peu d’oxygène et pas du tout d’éléments lourds (fer, carbone, etc.) qui, eux, apparaissent dans les générations suivantes d’étoiles précisément à la mort de ces étoiles dites primordiales… Un seul problème mais il est de taille : ces étoiles de première génération ont disparu dès le début de l’Univers, il y a 13,6 milliards d’années. Comment se pourrait-il qu’il en existe encore vers - 7 milliards d’années (puisque le sursaut gamma qui nous intéresse provient d’un endroit situé à 7 milliards d’années-lumière) ?

les étoiles primordiales que nous avons évoquées à plusieurs reprises sur ce blog. Au total, on se trouve devant une supergéante bleue presque exclusivement composée d’hydrogène et d’hélium avec très peu d’oxygène et pas du tout d’éléments lourds (fer, carbone, etc.) qui, eux, apparaissent dans les générations suivantes d’étoiles précisément à la mort de ces étoiles dites primordiales… Un seul problème mais il est de taille : ces étoiles de première génération ont disparu dès le début de l’Univers, il y a 13,6 milliards d’années. Comment se pourrait-il qu’il en existe encore vers - 7 milliards d’années (puisque le sursaut gamma qui nous intéresse provient d’un endroit situé à 7 milliards d’années-lumière) ?

C’est là qu’intervient l’observation de galaxies originales, en quelque sorte « marginales » dans le grand bal galactique. On sait que, normalement, les galaxies se remodèlent sans cesse et que les plus grosses avalent, « phagocytent » les plus petites qui sont trop proches et encore liées à elles par la gravité. Chaque fois, les nuages de gaz se percutant, c’est alors une débauche de nouvelles naissances d’étoiles, étoiles de plus en plus riches en éléments lourds. Toutefois, certaines galaxies semblent rester en dehors de cette vie agitée et on pense que c’est le cas de celle qui abrite le sursaut gamma GRB 101225A : une petite tache bleue bien au-delà d’Andromède. On y trouve sans doute ces étoiles géantes qu’on pensait disparues depuis des milliards d’années et qui s’y fabriquent peut-être encore…

Danger des sursauts gamma

Un sursaut gamma n’est pas seulement un phénomène extraordinaire comme l’Univers nous en propose parfois et l’élucidation de son mécanisme n’est pas qu’un jeu de l’esprit ou le simple désir d’expliquer les choses. C’est aussi un phénomène dont il faut se méfier… et qu’il est donc nécessaire de connaître le mieux possible !

On le disait précédemment : des sursauts gamma, on n’en a pas vu depuis des siècles dans notre galaxie et c’est tant mieux. À moins de 6000 années-lumière de nous, ce type de phénomène hautement énergétique pourrait être mortel pour la Terre. Il faut pour cela, comme on l’a vu, que le faisceau soit dirigé vers notre planète : il brillerait alors aussi fort que le Soleil ! La conséquence en serait une destruction importante de la  couche d’ozone (30 à 40% durant au moins 10 ans) avec pour résultat immédiat la mise à mal du phytoplancton, base de la chaîne alimentaire océanique. On ne parle évidemment pas des ravages que pourrait entraîner une telle situation sur la peau d’homo sapiens… Mais ce n’est pas tout. Il y aurait aussi une diminution de la photosynthèse avec un effondrement de la production alimentaire tandis que, dans le même temps, l’atmosphère terrestre se colorerait en permanence d’une teinte orange en raison de la formation d’oxyde de carbone… Toutes les chaînes alimentaires seraient touchées, au premier rang desquelles, évidemment, celles qui concernent l’Homme. Peut-être le début de sa fin de la domination sur la planète ! Il s’agit d’un risque qu’il ne faut pas prendre à la légère : de nombreux spécialistes pensent par exemple que c’est un sursaut gamma relativement proche qui pourrait expliquer l’extinction de masse de l’ordovicien il y a 440 millions d’années (60% des genres et 80% des espèces détruits).

couche d’ozone (30 à 40% durant au moins 10 ans) avec pour résultat immédiat la mise à mal du phytoplancton, base de la chaîne alimentaire océanique. On ne parle évidemment pas des ravages que pourrait entraîner une telle situation sur la peau d’homo sapiens… Mais ce n’est pas tout. Il y aurait aussi une diminution de la photosynthèse avec un effondrement de la production alimentaire tandis que, dans le même temps, l’atmosphère terrestre se colorerait en permanence d’une teinte orange en raison de la formation d’oxyde de carbone… Toutes les chaînes alimentaires seraient touchées, au premier rang desquelles, évidemment, celles qui concernent l’Homme. Peut-être le début de sa fin de la domination sur la planète ! Il s’agit d’un risque qu’il ne faut pas prendre à la légère : de nombreux spécialistes pensent par exemple que c’est un sursaut gamma relativement proche qui pourrait expliquer l’extinction de masse de l’ordovicien il y a 440 millions d’années (60% des genres et 80% des espèces détruits).

L’apparition d’un phénomène aussi violent peut, en revanche, apporter quelque chose de positif. Bien des astronomes pensent que la formation du système solaire à partir de son nuage de gaz primordial il y a 4,5 milliards d’années a été grandement facilité (si ce n’est réalisé) par l’explosion d’une supernova relativement proche et de son cortège de phénomènes éruptifs comme, peut-être, un important sursaut gamma. On peut donc en déduire sans trop risquer de se tromper que ce qui peut contribuer à donner la Vie peut également aboutir à sa destruction. Une leçon à méditer.

Sources :

1. Wikipedia France ; Wikipedia USA

2. Science & Vie, 1152, septembre 2013

3. Encyclopaedia Universalis

4. Encyclopaedia Britannica

Images :

1. sursaut gamma (sources : club.doctissimo.fr)

2. autre sursaut gamma (sources : astronomie.skyrock.com)

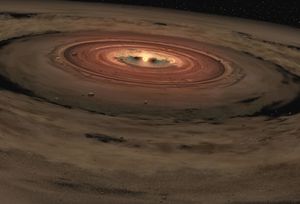

3. naissance d'une étoile géante (sources : skyimagelab.com)

4. supernova (sources : astrosurf.com)

5. trou noir et étoile à neutrons (sources : commons.wikimedia.org)

6. le satellite Swift (sources : nasa.gov)

7. supergéante bleue (sources : afhalifax.ca)

8.Terre détruite (sources : channel.nationalgeographic.com)

(pour lire les légendes des illustrations, posser le pointeur de la souris sur l'image)

Mots-clés : satellite Swift - satellite BeppoSax - rayonnement cosmique - étoile à neutrons - trou noir - supernova - étoile binaire - géante rouge - supergéante bleue - étoiles primordiales - extinction de masse de l'ordovicien

(les mots en gris renvoient à des sites d'information complémentaires)

Sujets apparentés sur le blog

6. la saga des rayons cosmiques

Dernier sommaire général du blog : cliquer ICI

l'actualité du blog se trouve sur FACEBOOK

mise à jour : 16 mars 2023

progressivement tandis qu’il s’enrichit en

progressivement tandis qu’il s’enrichit en  patineur tournant sur lui-même qui accélère sa vitesse de rotation en repliant ses bras. De plus, puisque ce protosystème est principalement composé de gaz concentré, il est encore souple et il peut donc

patineur tournant sur lui-même qui accélère sa vitesse de rotation en repliant ses bras. De plus, puisque ce protosystème est principalement composé de gaz concentré, il est encore souple et il peut donc  aux planètes que nous connaissons : dans le cas du système solaire, il aura fallu environ

aux planètes que nous connaissons : dans le cas du système solaire, il aura fallu environ  mais beaucoup plus grosses que les telluriques. Puisque le gaz disponible n’a qu’une durée de vie limitée à quelques millions d’années, il est nécessaire que ces planètes soient créées avant sa dissipation, donc assez rapidement (en termes géologiques).

mais beaucoup plus grosses que les telluriques. Puisque le gaz disponible n’a qu’une durée de vie limitée à quelques millions d’années, il est nécessaire que ces planètes soient créées avant sa dissipation, donc assez rapidement (en termes géologiques). à plus de 1000°. Comment cela est-il possible alors que, selon la théorie, une géante gazeuse ne peut naître que loin de son astre central ? Eh bien, disent les spécialistes, c’est qu’un Jupiter chaud comme Osiris est bien né loin de l’étoile mais s’en est ensuite rapproché par ce qu’on appelle une «

à plus de 1000°. Comment cela est-il possible alors que, selon la théorie, une géante gazeuse ne peut naître que loin de son astre central ? Eh bien, disent les spécialistes, c’est qu’un Jupiter chaud comme Osiris est bien né loin de l’étoile mais s’en est ensuite rapproché par ce qu’on appelle une «  disque autour de l’ensemble du système et des disques secondaires autour de chacune des étoiles, y compris la binaire : c’est là qu’est en train de se former tout un aréopage de planètes. D’ailleurs, on pense bien y avoir déjà mis en évidence une géante gazeuse. La théorie de formation des planètes n’était donc pas complète !

disque autour de l’ensemble du système et des disques secondaires autour de chacune des étoiles, y compris la binaire : c’est là qu’est en train de se former tout un aréopage de planètes. D’ailleurs, on pense bien y avoir déjà mis en évidence une géante gazeuse. La théorie de formation des planètes n’était donc pas complète ! voit donc au centre la protoétoile pas encore allumée et, autour d’elle, les cercles concentriques traduisant la

voit donc au centre la protoétoile pas encore allumée et, autour d’elle, les cercles concentriques traduisant la

descendants féconds

descendants féconds espèces et il rappela au passage qu’une spéciation résulte notamment de deux éléments très importants de l’Évolution : la

espèces et il rappela au passage qu’une spéciation résulte notamment de deux éléments très importants de l’Évolution : la  tantôt

tantôt  oiseaux pouvant se reproduire mais aux deux extrémités, les goélands bruns et les goélands argentés sont devenus des

oiseaux pouvant se reproduire mais aux deux extrémités, les goélands bruns et les goélands argentés sont devenus des  d’une même espèce. Interloqué, Darwin – qui n’avait pas noté les lieux de ses prélèvements – se reporta aux collectes des autres membres de l’expédition… pour s’apercevoir que chaque espèce de pinson correspondait à

d’une même espèce. Interloqué, Darwin – qui n’avait pas noté les lieux de ses prélèvements – se reporta aux collectes des autres membres de l’expédition… pour s’apercevoir que chaque espèce de pinson correspondait à  à

à

orques nagent en silence et ce sont elles qui attaquent les grands mammifères tels que phoques et otaries, lions de mer, marsouins, pingouins par échouage volontaire sur la terre ferme, voire baleines. De morphologie identique et habitant le même océan, ces deux types d’orques ne chassent pas les mêmes proies, n’ont pas la même façon de vocaliser… et

orques nagent en silence et ce sont elles qui attaquent les grands mammifères tels que phoques et otaries, lions de mer, marsouins, pingouins par échouage volontaire sur la terre ferme, voire baleines. De morphologie identique et habitant le même océan, ces deux types d’orques ne chassent pas les mêmes proies, n’ont pas la même façon de vocaliser… et  traduit à la fois l’imperfection dans la Nature et la réponse par le déterminisme et le hasard. En somme, le « progrès » vers un avenir radieux (d'ailleurs variable selon les sociétés humaines) est fictif : il n’existe que de simples transformations qui permettent à la Vie de se maintenir et, si possible, de s’étendre.

traduit à la fois l’imperfection dans la Nature et la réponse par le déterminisme et le hasard. En somme, le « progrès » vers un avenir radieux (d'ailleurs variable selon les sociétés humaines) est fictif : il n’existe que de simples transformations qui permettent à la Vie de se maintenir et, si possible, de s’étendre.

américain

américain  11 tonnes puisque, outre le miroir principal de 2,4 m, il est couplé à plusieurs spectromètres et trois caméras (la première à champ étroit destinée à observer les objets peu lumineux, la seconde pour les observations à champ large et enfin la troisième pour l’infrarouge). Puisque pour des raisons politico-écologiques il a été décidé de ne pas utiliser de source d’énergie d’origine nucléaire, la production d’électricité destinée à faire fonctionner le module est assurée par deux ensembles de panneaux solaires moins polémiques mais probablement plus difficiles à manipuler.

11 tonnes puisque, outre le miroir principal de 2,4 m, il est couplé à plusieurs spectromètres et trois caméras (la première à champ étroit destinée à observer les objets peu lumineux, la seconde pour les observations à champ large et enfin la troisième pour l’infrarouge). Puisque pour des raisons politico-écologiques il a été décidé de ne pas utiliser de source d’énergie d’origine nucléaire, la production d’électricité destinée à faire fonctionner le module est assurée par deux ensembles de panneaux solaires moins polémiques mais probablement plus difficiles à manipuler. du système solaire, événement confirmant au passage le rôle «

du système solaire, événement confirmant au passage le rôle «  notre

notre  ciel, région minuscule certes mais contenant déjà plusieurs milliers de galaxies. Cette photographie confirma ce que l’on soupçonnait auparavant, à savoir que, quelle que soit la direction dans laquelle on regarde, on trouve des

ciel, région minuscule certes mais contenant déjà plusieurs milliers de galaxies. Cette photographie confirma ce que l’on soupçonnait auparavant, à savoir que, quelle que soit la direction dans laquelle on regarde, on trouve des  image artificielle qui permet au système de calculer l’instabilité de l’air et d’adapter l’optique de l’instrument plus de mille fois par seconde… De ce fait, par exemple, bien que situé au sommet du Cerro Paranal (à 2600 m d’altitude), au Chili, le

image artificielle qui permet au système de calculer l’instabilité de l’air et d’adapter l’optique de l’instrument plus de mille fois par seconde… De ce fait, par exemple, bien que situé au sommet du Cerro Paranal (à 2600 m d’altitude), au Chili, le /image%2F1490480%2F20230317%2Fob_d6b173_telescope-james-webb.jpg)

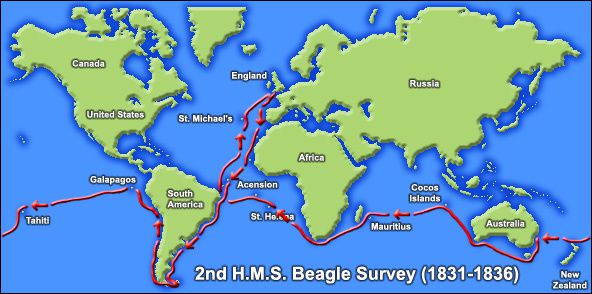

spécimens divers. Il séjourne quelques semaines dans la baie de Botafogo (aujourd’hui un quartier de Rio) et observe

spécimens divers. Il séjourne quelques semaines dans la baie de Botafogo (aujourd’hui un quartier de Rio) et observe  tatou actuel dont il vient de rencontrer des représentants (et en a même mangé quelques uns). Autre envoi d’échantillons, notamment des fossiles. Il faut préciser que le capitaine Fitzroy n’est pas mécontent de voir tous ces « déchets inutiles » qui encombrent son bateau disparaître enfin !

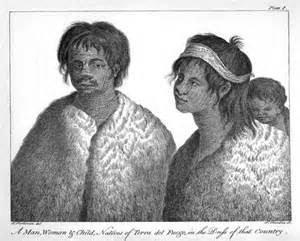

tatou actuel dont il vient de rencontrer des représentants (et en a même mangé quelques uns). Autre envoi d’échantillons, notamment des fossiles. Il faut préciser que le capitaine Fitzroy n’est pas mécontent de voir tous ces « déchets inutiles » qui encombrent son bateau disparaître enfin ! survivants « civilisés » dans leur terre d’origine. Le moins que l’on puisse dire est que les contacts ne sont pas si faciles avec les autochtones. Fitzroy décide de laisser les « indigènes éduqués » sur place à la tête d’une mission destinée à civiliser les autres : on repassera quelques mois plus tard voir comment tout cela aura évolué. Ce qui attire cette fois l’attention de Darwin ce sont les

survivants « civilisés » dans leur terre d’origine. Le moins que l’on puisse dire est que les contacts ne sont pas si faciles avec les autochtones. Fitzroy décide de laisser les « indigènes éduqués » sur place à la tête d’une mission destinée à civiliser les autres : on repassera quelques mois plus tard voir comment tout cela aura évolué. Ce qui attire cette fois l’attention de Darwin ce sont les  chilienne de Valvidia… pour y observer un terrible tremblement de terre qui détruit la cité. Toute la côte chilienne est d’ailleurs dévastée et Darwin comprend alors, en trouvant des pans rocheux couverts de concrétions marines

chilienne de Valvidia… pour y observer un terrible tremblement de terre qui détruit la cité. Toute la côte chilienne est d’ailleurs dévastée et Darwin comprend alors, en trouvant des pans rocheux couverts de concrétions marines  caractérisées par un climat souvent chaud et étouffant mais plutôt sec ; elles sont

caractérisées par un climat souvent chaud et étouffant mais plutôt sec ; elles sont

avec l’astronome John Herschel qui y réside. A Sainte Hélène, au pied du tombeau de Napoléon, il réfléchit à la transformation de la faune locale décimée par l’introduction

avec l’astronome John Herschel qui y réside. A Sainte Hélène, au pied du tombeau de Napoléon, il réfléchit à la transformation de la faune locale décimée par l’introduction  des variétés de crustacés (il avait auparavant publié son ouvrage sur les massifs coralliens, un travail qui lui avait pris près de trois ans). Mais le point d’orgue de son œuvre est bien entendu son ouvrage sur l’origine de espèces qu’il hésitera longtemps à faire connaître.

des variétés de crustacés (il avait auparavant publié son ouvrage sur les massifs coralliens, un travail qui lui avait pris près de trois ans). Mais le point d’orgue de son œuvre est bien entendu son ouvrage sur l’origine de espèces qu’il hésitera longtemps à faire connaître. antériorité. Wallace lui-aussi a recours à l’idée de sélection naturelle pour expliquer l’évolution progressive des espèces. Justice lui est d’ailleurs rendue aujourd’hui puisque la majorité des auteurs lui reconnaissent le titre de «

antériorité. Wallace lui-aussi a recours à l’idée de sélection naturelle pour expliquer l’évolution progressive des espèces. Justice lui est d’ailleurs rendue aujourd’hui puisque la majorité des auteurs lui reconnaissent le titre de «

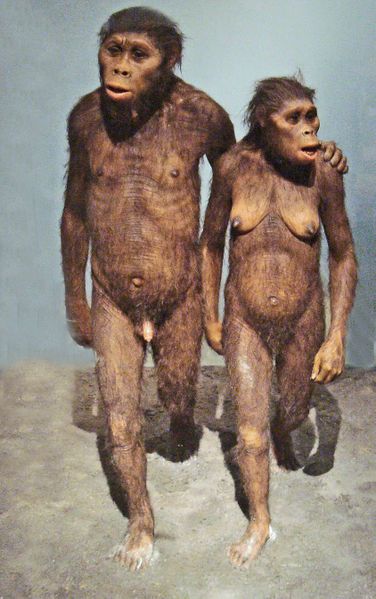

l’assimilation des nouvelles connaissances (mais, dans ce cas, pourquoi ne seraient-elles pas apparues « naturellement » ?). Non, la réalité est en fait bien plus besogneuse : des centaines de milliers d’années auront été nécessaires à différentes espèces de préhumains pour aboutir à la conscience de l’Homme moderne… ce qui par ailleurs conduit à réfuter un autre cliché : tout aurait commencé, disent certains, il y a environ 200 000 ans avec l’apparition d’Homo sapiens. Cette approche est notoirement fausse car l’Homme moderne n’est que l’aboutissement d’un processus engagé bien avant lui. C’est sur tout cela que je vous propose de revenir dans ce sujet.

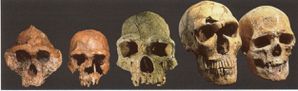

l’assimilation des nouvelles connaissances (mais, dans ce cas, pourquoi ne seraient-elles pas apparues « naturellement » ?). Non, la réalité est en fait bien plus besogneuse : des centaines de milliers d’années auront été nécessaires à différentes espèces de préhumains pour aboutir à la conscience de l’Homme moderne… ce qui par ailleurs conduit à réfuter un autre cliché : tout aurait commencé, disent certains, il y a environ 200 000 ans avec l’apparition d’Homo sapiens. Cette approche est notoirement fausse car l’Homme moderne n’est que l’aboutissement d’un processus engagé bien avant lui. C’est sur tout cela que je vous propose de revenir dans ce sujet. les catécholamines cérébrales par exemple). On avait tout faux. L’étude des boîtes crâniennes de nos précurseurs, ces hominidés jusque là perçus comme des primates sans réelle importance, montre à l’évidence qu’il y eut effectivement une évolution du volume des crânes au fil des centaines de milliers d’années mais que celle-ci fut lente : cela prit au moins deux millions d’années pour permettre aux 450 cc du cerveau des australopithèques de passer à 1000 cc chez homo erectus, puis environ 1300 cc chez Homo sapiens et Néandertal. Avec en prime, chez ces deux derniers Homo, le développement réel des hémisphères cérébraux, siège des fonctions dites supérieures…

les catécholamines cérébrales par exemple). On avait tout faux. L’étude des boîtes crâniennes de nos précurseurs, ces hominidés jusque là perçus comme des primates sans réelle importance, montre à l’évidence qu’il y eut effectivement une évolution du volume des crânes au fil des centaines de milliers d’années mais que celle-ci fut lente : cela prit au moins deux millions d’années pour permettre aux 450 cc du cerveau des australopithèques de passer à 1000 cc chez homo erectus, puis environ 1300 cc chez Homo sapiens et Néandertal. Avec en prime, chez ces deux derniers Homo, le développement réel des hémisphères cérébraux, siège des fonctions dites supérieures… collatérale. Certains d’entre eux (garhi, afarensis) avaient commencé à modeler des objets pour en faire des outils très rudimentaires. De nos jours, on sait que chimpanzés et gorilles utilisent des instruments simples (pour ouvrir des noix, pour vandaliser des termitières, etc.) mais les australopithèques semblent avoir été plus avancés en la matière ce qui en fait de vrais hominidés (bien que n’étant pas, répétons-le, des ancêtres directs de l’Homme moderne).

collatérale. Certains d’entre eux (garhi, afarensis) avaient commencé à modeler des objets pour en faire des outils très rudimentaires. De nos jours, on sait que chimpanzés et gorilles utilisent des instruments simples (pour ouvrir des noix, pour vandaliser des termitières, etc.) mais les australopithèques semblent avoir été plus avancés en la matière ce qui en fait de vrais hominidés (bien que n’étant pas, répétons-le, des ancêtres directs de l’Homme moderne). alimentaires, il n’est donc pas surprenant que Homo habilis ait cherché à développer des outils qui lui serviront à découper la viande et à casser les os longs pour en extraire leur moelle. Néanmoins, son adresse à fabriquer des outils reste quand même rudimentaire car, contrairement à ce que voudrait faire croire son nom (habilis = habileté), la morphologie de ses mains ne lui permet guère une manipulation très précise.

alimentaires, il n’est donc pas surprenant que Homo habilis ait cherché à développer des outils qui lui serviront à découper la viande et à casser les os longs pour en extraire leur moelle. Néanmoins, son adresse à fabriquer des outils reste quand même rudimentaire car, contrairement à ce que voudrait faire croire son nom (habilis = habileté), la morphologie de ses mains ne lui permet guère une manipulation très précise. environ 200 000 ans, il est, à ce jour, resté présent neuf fois plus longtemps que Sapiens). La maîtrise du feu est pour cet homo une étape fondamentale car cette capacité lui permet bien sûr de se réchauffer lors des nuits froides mais également, et peut-être surtout, de faire cuire ses aliments (permettant d’élargir leur choix tout en évitant nombre de maladies potentielles) et aussi de tenir les animaux dangereux à distance. On peut avancer sans risque de se tromper qu’en devenant dépositaire du feu, Erectus a permis aux homo de commencer à s’émanciper de la Nature et, ainsi, de faire un pas important vers l’organisation civilisée de la communauté humaine. Reste, évidemment, que le chemin à parcourir est encore long…

environ 200 000 ans, il est, à ce jour, resté présent neuf fois plus longtemps que Sapiens). La maîtrise du feu est pour cet homo une étape fondamentale car cette capacité lui permet bien sûr de se réchauffer lors des nuits froides mais également, et peut-être surtout, de faire cuire ses aliments (permettant d’élargir leur choix tout en évitant nombre de maladies potentielles) et aussi de tenir les animaux dangereux à distance. On peut avancer sans risque de se tromper qu’en devenant dépositaire du feu, Erectus a permis aux homo de commencer à s’émanciper de la Nature et, ainsi, de faire un pas important vers l’organisation civilisée de la communauté humaine. Reste, évidemment, que le chemin à parcourir est encore long… conduisent à considérablement améliorer la gamme de ses outils : c’est lui qui développe les bifaces symétriques et les hachereaux (petites « haches » réalisées sur un grand fragment de pierre comportant toujours un tranchant transversal non retouché). Fait notable, on note parfois dans la fabrication de certains bifaces un souci d’ordre esthétique, une disposition que l’on retrouve également avec l’utilisation de pigments et de colles (vers – 300 000 ans); par ailleurs, ses réalisations sont variables selon les différentes régions du monde ce qui prouve les capacités techniques certaines d’Erectus.

conduisent à considérablement améliorer la gamme de ses outils : c’est lui qui développe les bifaces symétriques et les hachereaux (petites « haches » réalisées sur un grand fragment de pierre comportant toujours un tranchant transversal non retouché). Fait notable, on note parfois dans la fabrication de certains bifaces un souci d’ordre esthétique, une disposition que l’on retrouve également avec l’utilisation de pigments et de colles (vers – 300 000 ans); par ailleurs, ses réalisations sont variables selon les différentes régions du monde ce qui prouve les capacités techniques certaines d’Erectus. excellemment taillé et jamais utilisé, dont on peut se demander s’il ne s’agit pas d’une offrande… Les spécialistes ne sont pas tous d’accord pour considérer ces « inhumations » collectives comme volontaires (certains pensent à des accidents ou à des catastrophes naturelles) et il faudra certainement trouver d’autres sites de ce genre pour conclure véritablement mais on se rapproche de plus en plus de cette dimension culturelle qui va pleinement apparaître avec Néandertal et, bien sûr, Sapiens.

excellemment taillé et jamais utilisé, dont on peut se demander s’il ne s’agit pas d’une offrande… Les spécialistes ne sont pas tous d’accord pour considérer ces « inhumations » collectives comme volontaires (certains pensent à des accidents ou à des catastrophes naturelles) et il faudra certainement trouver d’autres sites de ce genre pour conclure véritablement mais on se rapproche de plus en plus de cette dimension culturelle qui va pleinement apparaître avec Néandertal et, bien sûr, Sapiens. de la maîtrise du feu, il pouvait créer des objets ornementaux (voire complètement symboliques), faire de la gravure sur os ou fabriquer des parures en coquillages. Il avait une réelle vie sociale comme le prouve le crâne de ce Néandertalien (site de Shanidar, Irak) ayant subi un accident lorsqu’il était très jeune (fracture du crâne, destruction de l’orbite gauche et de la zone du cerveau contrôlant le côté droit de son corps) : en dépit de ce handicap sévère, le sujet put vivre jusqu'à 40-45 ans ce qui aurait été tout à fait impossible sans l’aide du groupe auquel il appartenait.

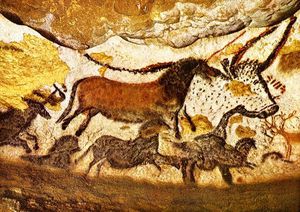

de la maîtrise du feu, il pouvait créer des objets ornementaux (voire complètement symboliques), faire de la gravure sur os ou fabriquer des parures en coquillages. Il avait une réelle vie sociale comme le prouve le crâne de ce Néandertalien (site de Shanidar, Irak) ayant subi un accident lorsqu’il était très jeune (fracture du crâne, destruction de l’orbite gauche et de la zone du cerveau contrôlant le côté droit de son corps) : en dépit de ce handicap sévère, le sujet put vivre jusqu'à 40-45 ans ce qui aurait été tout à fait impossible sans l’aide du groupe auquel il appartenait. les murs obscurs des cavernes, comme Néandertal certes, mais avec une richesse des couleurs et un art du dessin inégalés. Il crée des statuettes décoratives, embellit ses objets personnels, invente des parures en crocs ou en plumes tandis que les femmes se décorent de bijoux rudimentaires. Il s’extrait en somme du quotidien d’un monde de simple survie pour s’intéresser à autre chose. On comprend qu’il est le dernier maillon (pour l’instant) d’un long cheminement, commencé longtemps avant lui. Rapidement, en quelques milliers d’années, il domestique les animaux qui lui sont utiles, invente de nouvelles techniques, des outils, la transmission pérenne du savoir grâce à l’écriture et progresse peu à peu dans l’organisation sociale de ses communautés. L’éveil de la conscience humaine aura mis des centaines de milliers d’années mais, une fois apparue, cette dernière aura permis au seul Homo survivant de se développer rapidement jusqu’à occuper – et dominer – l’intégralité de la planète, à l’exception notable du continent antarctique.

les murs obscurs des cavernes, comme Néandertal certes, mais avec une richesse des couleurs et un art du dessin inégalés. Il crée des statuettes décoratives, embellit ses objets personnels, invente des parures en crocs ou en plumes tandis que les femmes se décorent de bijoux rudimentaires. Il s’extrait en somme du quotidien d’un monde de simple survie pour s’intéresser à autre chose. On comprend qu’il est le dernier maillon (pour l’instant) d’un long cheminement, commencé longtemps avant lui. Rapidement, en quelques milliers d’années, il domestique les animaux qui lui sont utiles, invente de nouvelles techniques, des outils, la transmission pérenne du savoir grâce à l’écriture et progresse peu à peu dans l’organisation sociale de ses communautés. L’éveil de la conscience humaine aura mis des centaines de milliers d’années mais, une fois apparue, cette dernière aura permis au seul Homo survivant de se développer rapidement jusqu’à occuper – et dominer – l’intégralité de la planète, à l’exception notable du continent antarctique.

du

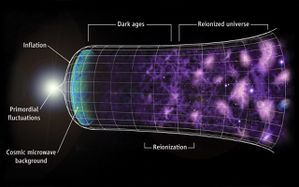

du  permettant de grossir énormément d'un seul coup (une très sérieuse preuve indirecte du phénomène semblait avoir eté apportée par de nouvelles observations le 17 mars 2014 mais il s'agissait d'une fausse alerte comme on pourra le lire en fin de cet article 1). L’univers du début est dans un état étrange où se mêlent matière (ou ce qui en tient lieu), espace et temps mais cela dure peu : jusqu’à 10-11 seconde car l’univers grossit en se dilatant. Qui dit expansion, dit

permettant de grossir énormément d'un seul coup (une très sérieuse preuve indirecte du phénomène semblait avoir eté apportée par de nouvelles observations le 17 mars 2014 mais il s'agissait d'une fausse alerte comme on pourra le lire en fin de cet article 1). L’univers du début est dans un état étrange où se mêlent matière (ou ce qui en tient lieu), espace et temps mais cela dure peu : jusqu’à 10-11 seconde car l’univers grossit en se dilatant. Qui dit expansion, dit  leur découverte) mirent en évidence (totalement par hasard comme souvent en science) le

leur découverte) mirent en évidence (totalement par hasard comme souvent en science) le  l’univers ne contenait jusque là que de l’hydrogène et de l’hélium : sans elles, aucune chance de voir apparaître nos mondes actuels et donc la Vie.

l’univers ne contenait jusque là que de l’hydrogène et de l’hélium : sans elles, aucune chance de voir apparaître nos mondes actuels et donc la Vie. à la même conclusion : non seulement, l’expansion de l’univers ne ralentit pas mais, au contraire,

à la même conclusion : non seulement, l’expansion de l’univers ne ralentit pas mais, au contraire,  appelle

appelle  ce temps là, il verra dans son ciel à peu près autant d’étoiles que nous en voyons aujourd’hui. En revanche, ses instruments d’optique auront beau scruter au-delà de sa supergalaxie, ils ne distingueront rien de plus : les autres supergalaxies seront

ce temps là, il verra dans son ciel à peu près autant d’étoiles que nous en voyons aujourd’hui. En revanche, ses instruments d’optique auront beau scruter au-delà de sa supergalaxie, ils ne distingueront rien de plus : les autres supergalaxies seront

rapport à celle qui varie selon les

rapport à celle qui varie selon les

un prédateur de disposer d’un organe visuel performant. Le champion toutes catégories est ici un petit animal appelé

un prédateur de disposer d’un organe visuel performant. Le champion toutes catégories est ici un petit animal appelé  les prédateurs. Certains, comme le chat, le loir, plusieurs espèces de renards ont des

les prédateurs. Certains, comme le chat, le loir, plusieurs espèces de renards ont des  populaire. De nombreux animaux ont mis en pratique cet adage. La

populaire. De nombreux animaux ont mis en pratique cet adage. La  jusqu’à 15 cm de profondeur et même de suivre leur trace s’ils ont été bougés. Un autre lézard, le varan géant appelé

jusqu’à 15 cm de profondeur et même de suivre leur trace s’ils ont été bougés. Un autre lézard, le varan géant appelé  Cette capacité concerne certains serpents comme les boas, les pythons et le crotale mais aussi la chauve-souris vampire. La proie est ici repérée par des

Cette capacité concerne certains serpents comme les boas, les pythons et le crotale mais aussi la chauve-souris vampire. La proie est ici repérée par des  les proies se précipitent vers ce phare dans la nuit noire sans voir la bouche du prédateur derrière. Ce poisson est d’ailleurs très spécial et je ne résiste pas à l’envie de vous raconter son mode de reproduction bien particulier. Le mâle est ici beaucoup plus petit que la femelle et il passe son temps à la chercher ; il la repère grâce à son odorat très développé et se colle à elle en la mordant et en libérant de ce fait une enzyme qui dissout sa bouche et la partie mordue de la femelle : les deux animaux fusionnent alors leurs systèmes sanguins et le mâle se met à mourir lentement en se dissolvant progressivement, d’abord les organes digestifs, puis le cerveau, les yeux, ne laissant au final qu’une paire de testicules qui libèrent alors le sperme. Bizarre, vous avez dit bizarre ?

les proies se précipitent vers ce phare dans la nuit noire sans voir la bouche du prédateur derrière. Ce poisson est d’ailleurs très spécial et je ne résiste pas à l’envie de vous raconter son mode de reproduction bien particulier. Le mâle est ici beaucoup plus petit que la femelle et il passe son temps à la chercher ; il la repère grâce à son odorat très développé et se colle à elle en la mordant et en libérant de ce fait une enzyme qui dissout sa bouche et la partie mordue de la femelle : les deux animaux fusionnent alors leurs systèmes sanguins et le mâle se met à mourir lentement en se dissolvant progressivement, d’abord les organes digestifs, puis le cerveau, les yeux, ne laissant au final qu’une paire de testicules qui libèrent alors le sperme. Bizarre, vous avez dit bizarre ? dont il fait même son terrier. On peut voir les difficultés que cette petite bête a à transporter sa « boule » le plus souvent bien plus grosse que lui dans l’excellent film « Microcosmos » sorti sur les écrans il y a quelques années. Mais comment fait-il pour se diriger toujours en droite ligne ? Eh bien, il se fie aux étoiles ou plus exactement à

dont il fait même son terrier. On peut voir les difficultés que cette petite bête a à transporter sa « boule » le plus souvent bien plus grosse que lui dans l’excellent film « Microcosmos » sorti sur les écrans il y a quelques années. Mais comment fait-il pour se diriger toujours en droite ligne ? Eh bien, il se fie aux étoiles ou plus exactement à

«

«  C’est dire que, rendus à une liberté totale, ils n’ont aucune peine à survivre en solitaires ! Aux USA, il existe plus de

C’est dire que, rendus à une liberté totale, ils n’ont aucune peine à survivre en solitaires ! Aux USA, il existe plus de  terrorisaient les passants. Les autorités locales ont dû prendre de sévères mesures pas toujours comprises des populations locales pour y mettre fin. Le même phénomène s’est produit il y a une vingtaine d’années sur

terrorisaient les passants. Les autorités locales ont dû prendre de sévères mesures pas toujours comprises des populations locales pour y mettre fin. Le même phénomène s’est produit il y a une vingtaine d’années sur  escarpés si bien qu’il est difficile pour un humain de les apercevoir. Ils se sont parfaitement adaptés à leur habitat sauvage au point que l’Homme a réussi à en introduire dans d’autres endroits comme dans les Alpes, la baie de Somme, voire les îles Canaries…

escarpés si bien qu’il est difficile pour un humain de les apercevoir. Ils se sont parfaitement adaptés à leur habitat sauvage au point que l’Homme a réussi à en introduire dans d’autres endroits comme dans les Alpes, la baie de Somme, voire les îles Canaries… peuvent mettre bas que par césarienne, pensons plutôt

peuvent mettre bas que par césarienne, pensons plutôt

et les petits mammifères menaçant un peu plus encore la biodiversité (le chat en liberté est considéré comme nuisible en Nouvelle-Zélande). Les autres soutiennent qu’il s’agit comme à chaque fois de partager l’espace avec ces nouvelles espèces qui finiront, un jour ou l’autre, par devenir des

et les petits mammifères menaçant un peu plus encore la biodiversité (le chat en liberté est considéré comme nuisible en Nouvelle-Zélande). Les autres soutiennent qu’il s’agit comme à chaque fois de partager l’espace avec ces nouvelles espèces qui finiront, un jour ou l’autre, par devenir des

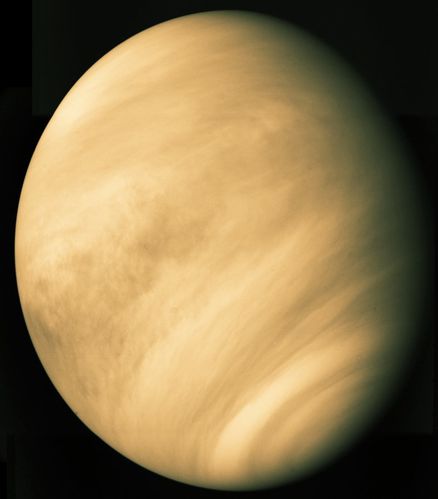

représenter le miroir à main de la déesse. En médecine, ce symbole désigne le sexe féminin (par opposition au symbole du dieu de la guerre,

représenter le miroir à main de la déesse. En médecine, ce symbole désigne le sexe féminin (par opposition au symbole du dieu de la guerre,  forme de croissant) tandis que les vraies étoiles, infiniment plus éloignées de nous, ne changent pas de forme. D’ailleurs, si on regarde Vénus un peu longtemps, on se rend compte assez vite qu’elle

forme de croissant) tandis que les vraies étoiles, infiniment plus éloignées de nous, ne changent pas de forme. D’ailleurs, si on regarde Vénus un peu longtemps, on se rend compte assez vite qu’elle  planètes du système solaire, par les Terriens tandis que

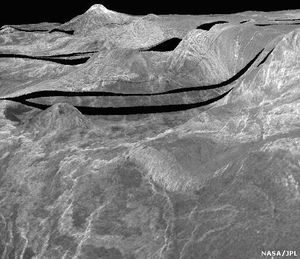

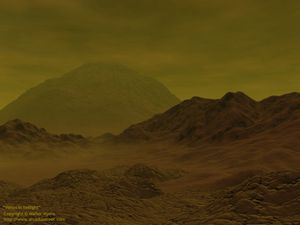

planètes du système solaire, par les Terriens tandis que  cartographie complète du sol vénusien et c’est aujourd’hui la sonde européenne

cartographie complète du sol vénusien et c’est aujourd’hui la sonde européenne  quarts par des

quarts par des  surface depuis plusieurs millions d’années et

surface depuis plusieurs millions d’années et représente 95% de la taille de la Terre pour 80% de sa masse ;

représente 95% de la taille de la Terre pour 80% de sa masse ;/image%2F1490480%2F20240420%2Fob_da5b95_toile-de-wolf-rayet-wr-124.jpg)

/image%2F1490480%2F20240213%2Fob_d2409a_jupiter-tourbillons-vus-par-juno.jpg)

/image%2F1490480%2F20231207%2Fob_babb88_nebuleuse-du-crayon.jpg)

/image%2F1490480%2F20230904%2Fob_d865b1_enrico-fermi.jpg)

/image%2F1490480%2F20230430%2Fob_25ae20_galaxie-cachee-ic-342.jpg)

/image%2F1490480%2F20230108%2Fob_68c405_voie-lactee-serge-brunier.jpg)