/image%2F1490480%2F20230908%2Fob_bd3552_ondes-gravitationnelles.jpg)

Einstein avait un problème avec la physique de Newton : il n’arrivait pas à comprendre comment elle acceptait qu’un objet éloigné puisse avoir une influence immédiate sur un autre corps puisque, pour lui, la vitesse de la lumière était finie et indépassable. Par ailleurs, les lois de Newton semblaient s’appliquer assez justement aux phénomènes observables dans notre environnement proche mais qu’en était-il au-delà ? Il s’attela donc à repenser entièrement l’ensemble de l’édifice théorique et à écrire les formules mathématiques justifiant une nouvelle approche. Dès 1905, il publia sa théorie de la relativité restreinte qui concernait les phénomènes utilisant des vitesses constantes avant, dix ans plus tard, de généraliser sa théorie en y incluant la gravitation.

Il expliqua que la physique newtonienne s’appliquait assez justement tant qu’elle ne concernait pas les « grands espaces » car, en effet, ses approximations, forcément infimes à notre échelle, ne sont guère perceptibles. Du coup et afin de convaincre les hésitants, sa théorie devait pouvoir corriger les « imprécisions newtoniennes » et c’est bien ce qu’il se passa. Il restait un phénomène prévu par la théorie d’Einstein mais jamais encore observé : les ondes gravitationnelles. C’est à présent - et depuis quelques mois - chose faite.

Les grandes lignes de la physique einsteinienne

Dans la théorie de la relativité restreinte qui, rappelons-le, ne concerne que les phénomènes se déroulant à vitesse constante, on trouve des éléments fondamentaux comme :

* la constance de la vitesse de la lumière (exactement 292 792 458 m/sec, soit un peu moins de

/image%2F1490480%2F20230908%2Fob_ace87b_albert-einstein.jpg)

300 000 km/sec),  vitesse indépassable. Dans le système solaire, les distances bien que gigantesques à nos yeux sont en réalité très modestes à l’échelle de l’Univers : elles se calculent en minutes-lumière, voire en heures-lumière pour l’éloignement des planètes géantes de notre système. Toutefois, l’étoile la plus proche du Soleil (alpha dite Proxima du Centaure) est actuellement située à près de 4 années-lumière et notre galaxie (qui mesure entre 70 000 et 100 000 années-lumière de longueur) est située à des millions d’années-lumière de sa proche voisine Andromède : nous ne sommes plus dans le même ordre de grandeur et les approximations de la physique newtonienne ne sont plus acceptables à si grande échelle.

vitesse indépassable. Dans le système solaire, les distances bien que gigantesques à nos yeux sont en réalité très modestes à l’échelle de l’Univers : elles se calculent en minutes-lumière, voire en heures-lumière pour l’éloignement des planètes géantes de notre système. Toutefois, l’étoile la plus proche du Soleil (alpha dite Proxima du Centaure) est actuellement située à près de 4 années-lumière et notre galaxie (qui mesure entre 70 000 et 100 000 années-lumière de longueur) est située à des millions d’années-lumière de sa proche voisine Andromède : nous ne sommes plus dans le même ordre de grandeur et les approximations de la physique newtonienne ne sont plus acceptables à si grande échelle.

* il existe une stricte équivalence entre énergie et matière comme le résume fort bien la célèbre formule E = mc2 (l’énergie d’un objet de masse m au repos est égale à sa masse que multiplie le carré de la vitesse de la lumière). Or, dans cette formule c2 est forcément gigantesque (le carré de 300 000 000 !) et cela veut donc dire que le fait de faire disparaître une infime quantité de matière m produit une énergie colossale. Pour illustrer cela, on prend souvent l’exemple d’un gramme de matière qu’on anéantirait avec un gramme d’antimatière : l’énergie produite serait équivalente à la bombe d’Hiroshima…

* l’espace et le temps sont liés et ne peuvent être dissociés. On vient de dire que la vitesse de la lumière ne pouvait être dépassée et qu’elle est constante dans un référentiel inerte (c’est-à-dire sans accélération) : de ce fait, si la vitesse de la lumière est constante, la variation ne peut venir que du temps… Le temps peut ralentir, s’accélérer voire se dilater indéfiniment ! Il s’agit d’une notion difficile à comprendre pour nos esprits confrontés à la petitesse de notre environnement. Bien entendu, les contemporains d’Einstein eurent eux aussi du mal à admettre ces notions et il leur fallait des preuves.

De plus, la relativité restreinte ne concerne, on vient de le dire, qu’une approche locale des phénomènes physiques, concernant des vitesses constantes, sans accélération. Ce qui ennuyait fortement Einstein qui souhaitait « généraliser » sa théorie à l’ensemble des situations et c’est la raison pour laquelle, dix ans plus tard, en 1915, il présenta une théorie de la relativité, générale cette fois.

Cette généralisation de la relativité restreinte intègre la gravitation et cela change beaucoup de choses. La

/image%2F1490480%2F20230908%2Fob_cc3964_geodesique-terre-lune.jpg)

première conséquence en est que, dans ce modèle, l’espace est déformable : tout objet entraîne la courbure plus ou moins importante de l’espace où il se trouve et l’importance de cette courbure sera proportionnelle à la valeur de sa masse. Du coup, l’espace déformé est une sorte de cuvette plus ou moins profonde au centre de laquelle siège l’objet et la distance entre deux points ne sera plus une ligne droite mais une ligne courbe plus ou moins inclinée selon la pente de la cuvette : on parle alors de géodésique.

conséquence en est que, dans ce modèle, l’espace est déformable : tout objet entraîne la courbure plus ou moins importante de l’espace où il se trouve et l’importance de cette courbure sera proportionnelle à la valeur de sa masse. Du coup, l’espace déformé est une sorte de cuvette plus ou moins profonde au centre de laquelle siège l’objet et la distance entre deux points ne sera plus une ligne droite mais une ligne courbe plus ou moins inclinée selon la pente de la cuvette : on parle alors de géodésique.

Au-delà de l’aspect quelque peu inhabituel du concept, on pourrait éventuellement penser qu’il s’agit en réalité de détails mais c’est tout le contraire. En effet, si un plus petit objet se trouve à proximité d’un plus gros, comme, par exemple, la Terre à proximité du Soleil, le plus petit s’approchera du plus gros en suivant une géodésique et non une ligne droite : il ne « tombera » alors pas sur le plus gros mais se mettra en orbite autour de lui… Cette courbure que l’objet le plus gros crée autour de lui et qui « capture » l’objet le plus petit se fait à la vitesse de la lumière et, du coup, la théorie répond à ce qui paraissait incompréhensible dans la physique newtonienne.

À la suite de la publication de sa théorie de la relativité générale, Einstein tenait quelque chose de complètement nouveau qui permettait d’avoir un regard neuf sur l’Univers et ses lois. Il n’en restait pas moins qu’il s’agissait d’une théorie, séduisante certainement, mais une théorie qu’il fallait valider.

Les preuves progressivement acquises

Nous ne reviendrons que succinctement sur les différentes « preuves » de la validité de la relativité générale, le sujet ayant déjà été traité (voir : théorie de la relativité générale).

La première réponse de la théorie concerna un problème exclusivement astronomique : l’avance du périhélie de Mercure, c’est-à-dire le point le plus proche de Mercure par rapport au Soleil, un problème que la physique de Newton ne savait pas résoudre : la Relativité l’explique parfaitement.

Vint ensuite la preuve par l’observation de mirages gravitationnels (ou lentilles gravitationnelles) : il s’agit ici

/image%2F1490480%2F20230908%2Fob_7886a0_croix-einstein.jpg)

du chemin parcouru par une lumière lointaine lorsqu’elle arrive à proximité d’un objet de masse importante situé entre elle et  l’observateur. Si l’espace est réellement courbé par l’objet, la lumière provenant de l’objet lointain prendra plusieurs chemins dans la « cuvette » ainsi formée (géodésiques) par l’objet intermédiaire et l’observateur verra l’image de l’objet lointain plusieurs fois… On profita d’une éclipse de soleil en 1919 (c’était lui l’objet massif) et on constata la déviation de la lumière d’étoiles fixes parfaitement connues au passage de notre étoile. C’était une confirmation éclatante de la théorie et nul ne se risqua plus à la mettre réellement en doute : son inventeur devint du jour au lendemain un des scientifiques les plus célèbres du monde.

l’observateur. Si l’espace est réellement courbé par l’objet, la lumière provenant de l’objet lointain prendra plusieurs chemins dans la « cuvette » ainsi formée (géodésiques) par l’objet intermédiaire et l’observateur verra l’image de l’objet lointain plusieurs fois… On profita d’une éclipse de soleil en 1919 (c’était lui l’objet massif) et on constata la déviation de la lumière d’étoiles fixes parfaitement connues au passage de notre étoile. C’était une confirmation éclatante de la théorie et nul ne se risqua plus à la mettre réellement en doute : son inventeur devint du jour au lendemain un des scientifiques les plus célèbres du monde.

D’autres expériences dites « relativistes » restaient à faire pour conforter le bien-fondé de la Relativité générale et, au fil des années, la technique aidant, elle furent réalisées, chaque fois avec un résultat positif. Toutefois, une preuve manquait à l’appel en raison de la grande difficulté à recueillir les informations sur le phénomène : l’observation d’ondes gravitationnelles.

Les ondes gravitationnelles

* la théorie

Puisque l’espace et le temps ne font qu’un, chaque fois qu’il se produit un événement massif dans l’Univers, la conséquence en est un réajustement local et la création de très faibles perturbations qui se propagent dans l’espace à la vitesse de la lumière. Ces ondulations ressemblent à celles qu’on peut observer à la surface d’un lac lorsqu’on y jette un caillou. Ce sont ces perturbations infimes de l’espace-temps que l’on appelle ondes gravitationnelles. En réalité, il existe deux types d’ondes gravitationnelles : celles qui sont apparues juste après le Big bang et qu’on appelle les ondes primordiales et celles qui correspondent aux déplacements d’objets massifs dans l’Univers.

Il s’agit d’un phénomène qui a été théorisé des 1916 par Einstein. Toutefois, on savait depuis le début qu’il serait très difficile d’enregistrer ces ondes car deux paramètres entrent en jeu : 1. La puissance du phénomène qui doit être majeur pour être perceptible (la simple explosion d’une étoile, même géante, ne suffisant pas) et 2. La finesse d’enregistrement des instruments susceptibles de mettre en évidence l’événement : on estime qu’un plissement gravitationnel entre la Terre et la Lune aurait l’épaisseur… d’un atome.

Ajoutons à cela que les scientifiques n’étaient pas certains de la validité de la théorie sur ce point précis ; Einstein lui-même était revenu à plusieurs reprises sur ce qu’il pensait, se demandant s’il existait vraiment une réalité physique au phénomène ou s’il ne s’agissait pas tout bêtement d’un problème mathématique dépendant du choix du système de coordonnées retenu, ce que les spécialistes appellent un « effet de jauge ».

* la première preuve indirecte

En 1974, deux astronomes américains, Russell Hulse et Joseph Taylor, étudiaient le pulsar PSR1913+16. Rappelons qu’un pulsar est le stade terminal de la vie d’une étoile massive, lorsque l’enveloppe externe de l’étoile a disparu et

/image%2F1490480%2F20230908%2Fob_7e5f41_pulsar.jpeg)

qu’il ne reste plus que qu’un cœur hypermassif sous forme d’une étoile à neutrons. Une étoile à neutrons tourne plusieurs centaines de fois par seconde sur elle-même, projetant un faisceau de radiations à la manière d’un phare d’où le nom de pulsar. Toutefois le pulsar étudié par les deux scientifiques avait la particularité d’être formé de deux étoiles à neutrons et, du coup, on pouvait calculer la période orbitale du couple. Or les calculs montraient que cette période orbitale décroissait d’un millième de seconde chaque année… très certainement du fait de la formation d’ondes gravitationnelles. Prix Nobel de physique pour les deux chercheurs en 1993 et grande avancée de la théorie de la relativité mais... on était toujours à la recherche d’une preuve directe.

étoile à neutrons tourne plusieurs centaines de fois par seconde sur elle-même, projetant un faisceau de radiations à la manière d’un phare d’où le nom de pulsar. Toutefois le pulsar étudié par les deux scientifiques avait la particularité d’être formé de deux étoiles à neutrons et, du coup, on pouvait calculer la période orbitale du couple. Or les calculs montraient que cette période orbitale décroissait d’un millième de seconde chaque année… très certainement du fait de la formation d’ondes gravitationnelles. Prix Nobel de physique pour les deux chercheurs en 1993 et grande avancée de la théorie de la relativité mais... on était toujours à la recherche d’une preuve directe.

* l’observation de LIGO

Le 14 septembre 2015, à très précisément 9h51 (temps universel) soit 11h51, heure de Paris, deux interféromètres,  situés à 3000 km l’un de l’autre et constituant l’expérience nommée LIGO (Laser Interferometer Gravitational-wave Observatory), enregistrèrent simultanément le passage d’une onde

situés à 3000 km l’un de l’autre et constituant l’expérience nommée LIGO (Laser Interferometer Gravitational-wave Observatory), enregistrèrent simultanément le passage d’une onde

/image%2F1490480%2F20230908%2Fob_c64cc1_ligo-aerial-video.jpg)

gravitationnelle. On a déjà dit qu’il fallait un événement considérable pour que puisse être mis en évidence cette très faible fluctuation de l’espace-temps : cet événement s’est produit il y 1,3 milliard d’années lors de la collision de deux trous noirs. On peut dire la chose différemment : en dépit de sa vitesse prodigieuse (300 000 km/sec), cette déformation parcourant l’Univers aura mis 1,3 milliard d’années à nous parvenir… Oui, l’Univers est immense…

Ce cataclysme ancien s’est produit quelque part dans l’hémisphère sud sidéral sans que l’on puisse apporter d'autres précisions (il aurait fallu plus d’interféromètres pour une meilleure localisation). Les deux trous noir « pesaient » respectivement 29 et 36 fois la masse du Soleil et ils ont fusionné dans un maelstrom cataclysmique pour aboutir à un super trou noir d’environ 62 masses solaires : les « 3 masses solaires manquantes » ont été converties en énergie précisément véhiculée par les ondes gravitationnelles. C'est cette contraction infinitésimale qu'ont enregistrée les capteurs de LIGO : infinitésimale, en effet, puisque la contraction de l'espace observée était de l'ordre de 100 000 milliards de fois inférieure à un cheveu !

Outre la mise en évidence des ondes gravitationnelles et la déformation de l’espace-temps, l’observation LIGO a dans le même temps définitivement établi l’existence des trous noirs dont quelques scientifiques doutaient encore. Et valider encore une fois s’il en était besoin la théorie einsteinienne de la relativité générale…

Une nouvelle astronomie

Il est entendu que le fait d’avoir enregistré pour la première fois des ondes gravitationnelles est un événement considérable, la consécration de la pensée théorique et de l’observation scientifique. Pourtant, ce n’est peut-être pas là le principal : en démontrant la réalité de ces ondes si longtemps recherchées, c’est tout l’avenir de l’astronomie des espaces lointains qui est transformé.

En effet, toute une partie de l’Histoire de l’Univers jusqu’à présent inaccessible avec nos outils classiques le devient grâce à l’interférométrie spécialisée : on imagine que l’explication d’événements tels que des coalescences de trous noirs, l'explosion d'étoiles géantes, la chute d’étoiles à neutrons sur l’horizon de trous noirs, bien d’autres phénomènes galactiques mal élucidés sont à portée de main. Mais on peut surtout espérer que cette nouvelle approche de l’exploration astronomique nous permettra de pénétrer les premiers instants de la formation de l’Univers, juste après le Big bang, durant ces fameuses 380 000 premières années alors que la lumière n’était pas encore apparue. On pourra donc peut-être voir au-delà du rayonnement fossile, ce fameux fonds diffus cosmologique qui était jusqu’à présent pour tous une limite indépassable…

/image%2F1490480%2F20230908%2Fob_c65748_rayonnement-fossile.jpg)

Cette percée marque la naissance d'un domaine de l'astrophysique entièrement nouveau, comparable au moment où Galilée a pointé pour la première fois son télescope vers le ciel au XVIIe siècle

(France Cordova, National Science Foundation, USA)

Sources :

* Wikipedia France (https://fr.wikipedia.org/)

* Revue Science et Avenir (http://www.sciencesetavenir.fr/)

* Jean-Pierre Luminet, astrophysicien

(http://blogs.futura-sciences.com/luminet/)

* journal Le Monde (http://www.lemonde.fr)

* revue Science & Vie (http://www.science-et-vie.com)

Images

1. vue d’artiste d’ondes gravitationnelles générées par la coalescence de deux trous noirs (source : tempsreel.nouvelobs.com)

2. Albert Einstein (sources : mirror.co.uk)

3. le couple Terre-Lune (sources : anarchies.e-monsite.com)

4. mirage gravitationnel "la croix d'Einstein (sources : univers-astronomie.fr)

5. vue d'artiste d'un pulsar (sources : maxisciences.com)

6. interféromètre du projet LIGO (sources : www.sciencemag.org/)

7. fonds diffus cosmologique (sources : astro.kizix.org)

Mots-clés : Albert Einstein - théorie de la relativité générale - avance du périhélie de Mercure - mirages gravitationnels - période orbitale - rayonnement fossile

Sujets apparentés sur le blog

1. théorie de la relativité générale

5. trous noirs

mise à jour : 19 mars 2023

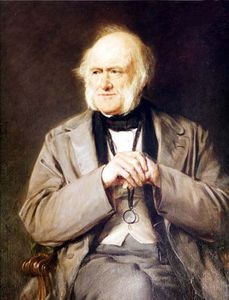

molécules) étaient la plus petite partie possible de la matière. En fait les atomes sont composés d’un

molécules) étaient la plus petite partie possible de la matière. En fait les atomes sont composés d’un  scientifiques belges,

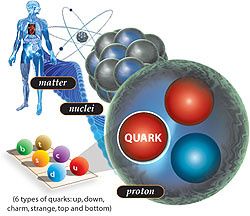

scientifiques belges,  particule de liaison) le

particule de liaison) le  principe ? Il s’agit d’accélérer des

principe ? Il s’agit d’accélérer des  création et la destruction des particules observées, les scientifiques ont pu conclure « à la très grande probabilité » (99,9%) de la découverte du boson de Higgs : vers la fin 2012, nous en aurons la confirmation définitive.

création et la destruction des particules observées, les scientifiques ont pu conclure « à la très grande probabilité » (99,9%) de la découverte du boson de Higgs : vers la fin 2012, nous en aurons la confirmation définitive./image%2F1490480%2F20230303%2Fob_ed093c_de-la-nebuleuse-protosolaire-au-system.jpg)

durée de temps obligatoirement fort longue (on ne connaissait pas encore la

durée de temps obligatoirement fort longue (on ne connaissait pas encore la  trompaient… Il entreprit de s’appuyer sur les

trompaient… Il entreprit de s’appuyer sur les  de cette querelle entre les géologues (et naturalistes) et les représentants de sa discipline… en donnant raison au camp opposé !

de cette querelle entre les géologues (et naturalistes) et les représentants de sa discipline… en donnant raison au camp opposé ! pour participer à un

pour participer à un

atomique est lui-même formé de structures plus petites, les

atomique est lui-même formé de structures plus petites, les Nous avons déjà eu l’occasion d’en parler longuement dans un sujet précédent (voir sujet

Nous avons déjà eu l’occasion d’en parler longuement dans un sujet précédent (voir sujet  universel est le boson de Higgs). Pour le mettre en évidence on a construit des outils spécifiques qui sont ici des

universel est le boson de Higgs). Pour le mettre en évidence on a construit des outils spécifiques qui sont ici des démenti par la théorie de la relativité générale. Si l’on y arrivait, on obtiendrait ce que certains appellent la

démenti par la théorie de la relativité générale. Si l’on y arrivait, on obtiendrait ce que certains appellent la

/image%2F1490480%2F20240420%2Fob_da5b95_toile-de-wolf-rayet-wr-124.jpg)

/image%2F1490480%2F20240213%2Fob_d2409a_jupiter-tourbillons-vus-par-juno.jpg)

/image%2F1490480%2F20231207%2Fob_babb88_nebuleuse-du-crayon.jpg)

/image%2F1490480%2F20230904%2Fob_d865b1_enrico-fermi.jpg)

/image%2F1490480%2F20230430%2Fob_25ae20_galaxie-cachee-ic-342.jpg)

/image%2F1490480%2F20230108%2Fob_68c405_voie-lactee-serge-brunier.jpg)